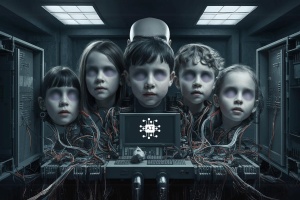

Las fotografías de niños se están “utilizando ilegalmente para entrenar la IA”.

Según Human Rights Watch, se están utilizando fotografías personales de niños brasileños sin su conocimiento o consentimiento para desarrollar sofisticadas herramientas de inteligencia artificial (IA). Según se informa, estas imágenes se recopilan de Internet y se compilan en extensos conjuntos de datos, que las empresas utilizan para mejorar sus tecnologías de inteligencia artificial.

En consecuencia, se dice que estas herramientas se emplean para producir deepfakes dañinos, lo que aumenta el riesgo de explotación y daño a más niños.

Hye Jung Han, investigadora de tecnología y derechos de los niños y defensora de Human Rights Watch, dijo: “Los niños no deberían tener que vivir con el miedo de que sus fotos sean robadas y utilizadas como arma contra ellos.

El gobierno debería adoptar urgentemente políticas para proteger los datos de los niños del mal uso impulsado por la IA”, continuó, advirtiendo: “La IA generativa es todavía una tecnología incipiente, y el daño asociado que los niños ya están experimentando no es inevitable. Proteger ahora la privacidad de los datos de los niños ayudará a que el desarrollo de esta tecnología promueva, en lugar de violar, los derechos de los niños.

¿Se utilizan imágenes de niños para entrenar la IA?

La investigación reveló que LAION-5B, un importante conjunto de datos utilizado por destacadas aplicaciones de inteligencia artificial y compilado mediante el rastreo de grandes cantidades de contenido en línea, incluye enlaces a imágenes identificables de niños brasileños.

Estas imágenes suelen incluir los nombres de los niños en el título o en la URL donde está alojada la imagen. En varios ejemplos, es posible rastrear las identidades de los niños, revelando detalles sobre la hora y el lugar en que se tomaron las fotografías. Según WIRED, se ha utilizado para entrenar varios modelos de IA, como la herramienta de generación de imágenes Stable Diffusion de Stability AI.

Human Rights Watch identificó 170 imágenes de niños en al menos 10 estados brasileños, incluidos Alagoas, Bahía, Ceará, Mato Grosso do Sul, Minas Gerais, Paraná, Río de Janeiro, Rio Grande do Sul, Santa Catarina y São Paulo, desde fechas tan lejanas. como a mediados de los años 1990. Es probable que esta cifra represente solo una fracción de los datos personales de los niños en LAION-5B, ya que solo se revisó menos del 0,0001 por ciento de los 5.850 millones de imágenes y leyendas del conjunto de datos.

La organización afirma que al menos 85 niñas de algunos de estos estados brasileños han sido objeto de acoso. Sus compañeros de clase hicieron un mal uso de la tecnología de inteligencia artificial para crear deepfakes sexualmente explícitos utilizando fotografías de los perfiles de las redes sociales de las niñas y posteriormente distribuyeron estas imágenes manipuladas en línea.

LAION responde a las reclamaciones

En respuesta, LAION, la organización alemana de inteligencia artificial que supervisa LAION-5B, reconoció que el conjunto de datos utilizaba algunas fotografías de niños identificadas por Human Rights Watch y se comprometió a eliminarlas. Sin embargo, cuestionó que los modelos de IA entrenados en LAION-5B pudieran copiar exactamente datos personales. LAION también afirmó que era responsabilidad de los niños y sus tutores eliminar fotos personales de Internet, argumentando que era la mejor manera de evitar el uso indebido.

En diciembre, el Observatorio de Internet de la Universidad de Stanford informó que LAION-5B contenía miles de imágenes sospechosas de abuso sexual infantil. LAION desconectó el conjunto de datos y emitió un comunicado diciendo que “tiene una política de tolerancia cero para el contenido ilegal”.